Los algoritmos y la Big Data

Índice Artículo

Los algoritmos y la Big Data, para la informática, la lógica y las matemáticas, un algoritmo es una serie de reglas o instrucciones completamente definidas, ordenadas, nada ambiguas y finitas, diseñadas para efectuar un cómputo, procesar una información, resolver un problema, entre otra clase de tareas o actividades. Para ello, debe existir una entrada y un estado inicial. Posteriormente, con el seguimiento de una serie de pasos se puede alcanzar un estado final para solventar la exigencia o petición.

En nuestra cotidianidad, son empleados una serie de algoritmos con mucha frecuencia para resolver toda clase de problemas. Un caso son los algoritmos insertados en los manuales de usuario de diversos productos, que exhiben en su contenido un algoritmo para definir el uso de un aparato. Las instrucciones que un trabajador puede recibir de su patrón, serían otro ejemplo de algoritmo. En la matemática, los procesos de multiplicación y división implican el uso de algoritmos, mientras que el máximo común divisor de dos números enteros, invoca al algoritmo de Euclides y el método de Gauss es otro algoritmo con el que se resuelve un sistema de ecuaciones lineales. En el ámbito de la programación, el algoritmo consiste en una concatenación de pasos que conllevan una lógica con la que se puede resolver un problema.

Los algoritmos son muy usados en Internet

Aunque no lo crea, desde hace bastante tiempo se usan los algoritmos en Internet, sobre todo en los buscadores como Bing, Google, entre otros. Los algoritmos para los motores de búsqueda en Internet, engloban una serie de instrucciones con las que se detalla el procedimiento a ejecutar para que el usuario de la red de redes encuentre un resultado preciso dentro de Internet, enmarcado en una plataforma de datos de mayor amplitud.

De esta manera quedan prescritas las acciones que se harán, para que dentro de las búsquedas que un usuario haga en cualquiera de estos motores, se obtenga una finalidad específica. Claro, se podría pensar que una instrucción sería un algoritmo si ninguna de sus instrucciones permite distintas variantes del desarrollo de la actividad y si las mismas sirven para ser ejecutadas en cualquier escenario.

Entonces, si un usuario hace una búsqueda de información en Google, lo hace con la intención de encontrar una respuesta puntual, y no ver el contenido de un gran volumen de páginas que para nada se relaciona con lo que está pidiendo. Por eso, los algoritmos significan un instrumento adecuado para delimitar dicha búsqueda a una expresión pequeña, trabajando como un software informático que indaga por medio de pistas para proporcionar al usuario con exactitud lo que solicitó.

Otra cosa que puede hacer un algoritmo, es identificar una pregunta y convertirla en una lista con posibles respuestas y en el caso de los algoritmos de búsqueda de Google, se basan en señales o factores únicos, con los que se puede adivinar lo que se busca en Internet, para obtener de esta manera varias respuestas de manera simultánea ordenadas de mayor a menor relevancia.

Saber la manera en que puede funcionar un algoritmo de un buscador, es algo útil para muchas personas, sobre todo para quienes hacen vida de alguna manera en Internet, sobre todo para quienes buscan a diario posicionar contenidos o para los que de alguna forma, usan estos programas informáticos con el propósito de hacer llegar sus contenidos a una audiencia o publico específico. A continuación, veremos las cualidades de los algoritmos de algunos motores de búsqueda de Internet.

¿Cómo funciona el buscador de Google?

El motor de búsqueda de Google es el más célebre de la red de redes por ser el más usado por los internautas, amén que su algoritmo se actualiza periódicamente, lo que hace que tenga un funcionamiento orientado hacia la WPO de una página web y posicionando mejor los contenidos de calidad, que de por si se adapten mejor a las intenciones de búsqueda de los usuarios, respondiendo estas peticiones en un tiempo sumamente corto.

La cuota de mercado de este motor de búsqueda se acerca al 80%, asumiendo más de 40.000 millones de peticiones de búsquedas e indexando por lo menos 25 millones de web-sites mensuales, aparte que tienen indexados una buena cantidad de billones de documentos. Este buscador, nació como un proyecto académico creado por Sergey Brin y Larry Page, quienes estudiaban en la Universidad de Stanford. En 1996, laboraban para un sistema de buscadores denominado BackRub, lo que les sirvió de experiencia para hacer el motor de búsqueda Google.

A lo largo del tiempo, el motor de búsqueda de Google ha mantenido distintos algoritmos de búsqueda, que han funcionado de manera distinta, tratando de concretar una evolución al modo en que funciona el buscador para efectos de proporcionar la información de interés para el usuario.

Google Panda

Este buscador experimentó una actualización en junio de 2010 denominada “Caffeine”, que implicó mayor rapidez para efectos de rastreo, una indexación expandida e integrada y clasificación de las webs en un tiempo prácticamente real. Mientras que en febrero de 2011, Google pone en funcionamiento la actualización de espectro amplio “Panda”, con la que afectó al menos a un 12% de los queries. Recordemos que un query, es el concepto o término escrito en el campo del motor de búsqueda, cuando se hace una indagación basada en keywords o palabras clave, para obtener una página de resultados de búsquedas con sus entradas correspondientes.

Gracias a esta actualización, Google consiguió enfrentar al web scraping (técnica con la que se extrae contenido de páginas web mediante el uso de un software), las granjas de contenido, el spam, y las webs con una gran cantidad de anuncios si se compara con el porcentaje de contenido que posean. En el transcurso de 2011, Google lanza la versión 2.1 de “Panda”, cambio que mejora la indexación de páginas y la experiencia de los internautas. Este algoritmo funciona en casi todos los idiomas con la versión “Panda” 2.4, a excepción de los lenguajes coreano, japonés y chino. A mediados de 2014, dan a conocer la versión 4.0 y a fines de ese año, se conoce “Panda” 4.1. En el core general de búsqueda queda integrado “Panda” por parte de Google durante el 2015.

Google Freshness

Es una actualización a nivel del algoritmo de este motor de búsqueda, que prioriza los resultados de las indagaciones más recientes, lo cual cambia con la actualización denominada “Venice” de febrero de 2012, cuando se priorizan los resultados de la búsqueda de cada usuario, pero con respecto a su geo-localización.

Google Penguin

Es una actualización del algoritmo con la que se penaliza a las páginas web, que emplean técnicas derivadas del “black hat SEO”, con la finalidad de concretar una mejora del posicionamiento de un dominio determinado artificialmente. Una de las metas planteadas con “Penguin”, es suprimir el spamdexing, dado que es un método con el que se manipula fraudulentamente la relevancia que tenga una página indexada por el buscador. Además, Penguin presenta como prioridad dejar en las primeras posiciones de los resultados de búsqueda de Google a las web sites que tengan contenidos de la más alta calidad.

Para el mes de septiembre de 2016, “Penguin” es integrado por completo al algoritmo principal del buscador, logrando que este trabaje en tiempo real con mayor efectividad, a tal punto que su clasificación es más precisa porque no afecta de manera general a una página web, sino individualmente a cada dirección URL.

Google Hummingbird

“Hummingbird” es la actualización más preponderante al algoritmo del motor de búsqueda después de “Caffeine”, pensada para concretar una evolución en el proceso de indexación. Asimismo, con Google “Hummingbirg” no solo se tiene en cuenta cada una de los términos de query de forma individual, sino que abarca la búsqueda hecha de manera general porque toma en cuenta la oración o frase, para que el motor de búsqueda comprenda las relaciones que existen entre los conceptos y las palabras clave, lo cual propiciaría una experiencia de usuario más humana, apostando por las indagaciones semánticas, porque así se contempla el significado de cada expresión con resultados de búsqueda que sean verdaderamente importantes para el internauta.

Con la actualización “Hummingbird” no existe tanta variación a nivel del SEO, porque su orientación principal es que los resultados de búsqueda mejor posicionados cuenten con un contenido relevante y natural, buscando que las palabras clave del tipo long tail (larga cola) queden correctamente posicionadas, porque estas al ser muy naturales son adecuadas para responder a las preguntas que realice cada usuario. Esto obliga a los creadores de contenido a que los textos producidos sean afines al uso normal y corriente de las palabras, enfocándolos a conversaciones que sean plenamente reales y no a una serie de keywords o palabras claves que muchos expertos en SEO insertan en sus páginas de Internet.

Para el año 2014 es lanzada la update Google “Pigeon”, que sirvió para priorizar a esos resultados de búsqueda cercanos, criterio geográfico que beneficia a emprendedores locales y negocios pequeños del tipo PYME (pequeña y mediana empresa). También, como una medida de seguridad, Google expresa públicamente su predilección por las web sites que emplean el protocolo HTTPS y en 2015, pone en marcha una update que ayuda a los sitios de la red de redes con mejor exposición en dispositivos móviles como tablets y smartphones gracias a un diseño responsivo, sin que esto influya en los resultados de las búsquedas hechas con el ordenador.

Por ende, Google hizo hincapié en que las páginas web deben ser “mobile frendly”, aparte que en marzo de 2015 mencionó a los administradores de páginas web que tenían intenciones de implementar una actualización del algoritmo con la que los usuarios pudieran conseguir resultados de búsqueda basados en páginas amigables y relevantes a sus terminales móviles.

¿Cómo funciona el motor de búsqueda Yandex?

La empresa CompTek es la responsable de su creación en 1988, a pesar que este buscador se puso a disposición del público el 23 de septiembre de 1997, después de darse a conocer en 1993 su primera versión, solo que en un principio, estaba concebida para conseguir información particularmente en una página de Internet. Es necesario destacar, que Yandex no es el primer buscador hecho en Rusia, puesto que ya eran conocidos Aport y Rambler. Sin embargo, su popularidad aumentó paulatinamente, a tal punto que consiguió el liderato del sector en Rusia desde el 2001.

En la actualidad, Yandex es la empresa de Internet más importante en Europa, tomando en cuenta su capital de 10 mil millones de dólares que ostentaba hasta el año 2013 y en ese mismo año, su buscador “Yandeks.Poisk” era el cuarto más importante a escala global, con casi cinco mil millones de indagaciones, aparte que entre los motores de búsqueda que usan un lenguaje no anglosajón es el segundo, quedando por detrás de Baidu.

Yandex y su actualización de algoritmo “Magadan”

Para el 2008 Yandex dio a conocer su actualización de algoritmo “Magadan”, con la que resolvieron el inconveniente para interpretar las abreviaturas, aparte que consiguieron manejar adecuadamente tanto la transliteración como la correlación entre las palabras que tengan una raíz similar. Posteriormente, a “Magadan” le hacen una actualización con la adición de nuevos factores de ranking entre los que destacan la priorización en los resultados de búsqueda de contenidos exclusivos.

Después, se dan a conocer los updates “Arzamás” y “Najodka”, que ayudaron al mejoramiento de resultados con queries que tengan preposiciones y conjunciones. Así se consigue que las páginas de resultados de búsqueda tengan más información de interés para el usuario, lo que implica contenidos vinculados con su localización geográfica.

Yandex crea la actualización Snezhinsk

“Snezhinsk” implica una tecnología de mayor complejidad, con la que se analiza el contenido de cada página, tomando en cuenta una gran cantidad de factores y destacando entre la existencia del contenido de calidad, para lo que verifican si este es realmente relevante. En septiembre de 2010 se conoce a la actualización “Obninsk”, con la que se avoca a encontrar los SEO-enlaces (que no son otra cosa sino backlinks previamente pagados), tratando de disminuir su impacto para posicionar páginas.

Con Kaliningrado se personaliza la experiencia de búsqueda del usuario

En diciembre de 2012, al motor de búsqueda Yandex le hacen su actualización denominada “Kaliningrado”, con la que se personaliza el proceso de búsqueda que emprende el usuario de acuerdo a sus intereses, por lo que la información vinculada con lo que haga el usuario es actualizada diariamente, y será segmentada tomando en cuenta el tiempo que dure la búsqueda y su personalización, motivo por el que el SEO dentro de este buscador no solo comprende a las palabras clave preponderantes y los backlinks, sino del contenido y la usabilidad.

A esta actualización le hacen un upgrade en 2013 llamado “Dublin”, para que el motor de búsqueda comience a memorizar las acciones que el usuario haya ejecutado recientemente. Para abril de 2015, en Yandex los backlinks que sean pagados no son un factor de influencia al momento de rankear las web-sites, razón por la que se libran del spam de backlinks para que los propietarios de los dominios se enfoquen a nivel del SEO en mejorar el contenido de sus páginas y al mismo tiempo, que estas tengan un diseño accesible y presten un mejor servicio. Por eso, ya no es importante tener backlinks pagados de acuerdo a las determinaciones de Yandex.

Microsoft y su motor de búsqueda Bing

Bing es el buscador diseñado por Microsoft y que fue presentado al público a mediados de 2009, con lo que reemplazaron a Yahoo Search, siendo lanzado al mismo tiempo que la araña web MSN bot 2. Hoy en día, Bing tiene el segundo lugar dentro del ranking de motores de búsqueda, de acuerdo al volumen de tráfico online que manejan.

A diferencia de los buscadores de Google y Yandex, Microsoft no divulga las actualizaciones de algoritmo que ellos hacen a su motor de búsqueda Bing. Lo que si es cierto es que en el marco de su funcionamiento, Bing presta atención especial a las webs cuyos contenidos tengan imágenes, audios, videos y la tecnología Flash Player (que ya es reemplazada por HTML5), amén que toma muy en cuenta las keywords o palabras clave directas y concretas, lo que tiene mucho peso en la estrategia SEO de cara a la indexación y posicionamiento en Bing.

Microsoft hizo pública en 2011 que trabajaba en una actualización del algoritmo de Bing a la que llamó “Tiger”, con la que pretendía mostrar resultados con mayor rapidez y relevancia para los usuarios, producto de una mejora al procesar queries, aunque esto va en detrimento de los backlinks. Además, Bing prefiere posicionar de mejor manera a páginas con un alto nivel de interacción o engagement en las redes sociales.

Los algoritmos y la big data representan un poder

En la actualidad las redes sociales representan el epicentro de la cotidianidad en Internet, ya que son espacios virtuales con contenidos que se adaptan a las preferencias de cualquier usuario. Se trata de una manera novedosa de comunicación que puede servir para muchas cosas, sobre todo si de aspirar a un cargo de elección popular se trata, porque la interacción a nivel de las redes sociales pueden ayudar a un candidato a individualizar sus mensajes y propuestas políticas para que cada quien escuche lo que desee y aspira de este individuo, dirigiendo el proceso comunicacional forma específica a cada votante, tal cual como sucedió en la campaña electoral de las elecciones presidenciales del año 2016 en Estados Unidos.

Es algo que se facilita porque gran parte del electorado no está realmente informado, acerca del acontecer político, social, económico e histórico del lugar donde se encuentra, aparte que muchas personas no conocen realmente a quienes visualizan como referentes de la clase política y que simultáneamente poseen el control y dominio de este tipo de medios electrónicos de difusión de contenidos en tiempo real durante las 24 horas del día.

También, sucede que la fragmentación social se expande infinitamente a medida que se especifican las identidades en cuanto al estilo de vida y hábito de consumo de cada individuo y no propiamente por pertenecer a una clase social o mantener una posición ideológica, lo que obliga a las distintas organizaciones políticas a reformular sus campañas propagandísticas de cara a su participación en futuros procesos electorales. Y esta fragmentación del sujeto moderno continuará por lo que resta de este siglo hasta un punto en el que es muy difícil que exista un retorno a un estado anterior, algo que conocen a cabalidad quienes ponen en práctica técnicas de marketing para delimitar el mensaje con el que abordarán a sus clientes probables.

Entonces, gracias a las redes sociales se pueden obtener una gran cantidad de información a la que se puede denominar macrodatos, datos a gran escala o con el término anglosajón Big Data, pudiendo definir esto como un conjunto de información y datos de un gran volumen y complejidad, que deben ser manejados y procesados con aplicaciones informáticas no tradicionales, que ayudarán a la detección de patrones que sean repetitivos con respecto al comportamiento de los usuarios, lo que posibilita pronosticar cualquier evento con antelación mediante lo que se haya observado con un análisis previo, que permite la creación de informes estadísticos que tengan un carácter predictivo, siendo esto lo que proporciona valor agregado a la información recolectada.

La Big Data se relaciona con las tecnologías de la información y la comunicación, ya que es una disciplina que trata sobre el manejo de enormes volúmenes de datos, comprendiendo las dificultades que puedan presentarse para gestionar esta cantidad de información en cuanto a su obtención y resguardo.

Durante mucho tiempo, los medios de comunicación y difusión de información tradicionales (cine, prensa, radio y televisión), fueron pilar fundamental en muchos países para la consolidación de lo que conocemos como democracia, especialmente en lo que tiene que ver con la participación de la gente en los comicios a los que por algún motivo eran convocados. Los grupos de poder manejan estos medios para conseguir la mayor cantidad de votantes posibles a su favor, mediante una interacción continua usando toda clase de contenidos pero desde la perspectiva que consta de un emisor de mensajes, hacia una gran cantidad de receptores quienes atraparán todo el discurso del candidato, lo que obligaba a este a hacerse entender en cuanto a asuntos de interés público que fueran pertinentes, construyendo así la agenda de los ámbitos cultural, económico, político, social, etc.

Con las redes sociales esto cambió, porque la gente puede acceder a cualquier contenido a toda hora sin importar el sitio en que se encuentre, siempre que cuente con conexión a Internet. Claro está su comportamiento ha cambiado porque el individuo de hoy tiene a su disposición a una gran cantidad de videos, audios, textos, imágenes, con los que no se aburrirá ni un instante. Mediante las redes sociales se puede llegar a esta clase de personas, lo que en primera instancia se usó para finalidades publicitarias.

De ahí el éxito financiero de Facebook, empresa de social media que frecuentemente almacena una gran cantidad de datos de sus usuarios, para conocer sus intereses, los sitios que frecuentan, sus amigos y familiares, los horarios en los que habitualmente se conectan, las instituciones en donde cursaron estudios y las empresas para las cuales trabajan o en su defecto, las actividades económicas a las que se dedican y muchas otras cosas más.

Desde el punto de vista publicitario, con esta Big Data Facebook puede establecer una serie de perfiles para crear mensajes que enviarán de forma selectiva. Por ejemplo, a las madres de niños pequeños les envía mensajes publicitarios sobre marcas de pañales, mientras que a quienes gusten de las bebidas les manda anuncios de productos vinícolas y a los que visitaron páginas de agencias de viajes les harán saber de ofertas relacionadas con destinos turísticos.

Aparte de recoger información dejada por los usuarios tanto en sus páginas como en otras webs, en las que existe un dedo pulgar de esta red social para manifestar un like o “me gusta”, esta compañía obtiene datos de otras fuentes como el sistema de mensajería instantánea WhatsApp, que compró en 2014 tras pagar 19.000 millones de dólares y con la que pueden llegar a los móviles inteligentes, donde cada usuario tiene sus contenidos más íntimos y valiosos.

Esto es una evidencia con respecto al poder que tendrá quien acceda a toda esta información, porque tendrá la potestad de descubrir correlaciones y patrones, gracias a la visualización en tiempo real de la información sobre el comportamiento social de la población y así saber de las cosas que la gente habla, los horarios en que establece este tipo de comunicaciones, el lugar desde el cual se comunica y las personas con las que comparte en estos espacios virtuales.

Volviendo al caso de Facebook, como maneja un gran volumen de datos en tiempo real, esta es una red social de publicidad con encuestas que se realizan de manera permanente, para hacer contenidos individualizados dirigidos a un tipo específico de persona. Además, los usuarios que serían clientes potenciales para recibir estos mensajes con intenciones publicitarias, serán quienes produzcan los contenidos con los que harán que otras personas se interesen en lo que se está promocionando.

Aquí es donde esta red social se desmarca de los medios tradicionales, que implicarían la contratación de periodistas, locutores, productores, camarógrafos, asistentes de sonido, fotógrafos, entre otros, quienes se encargarán de la producción de contenidos, trabajo que en las redes sociales lo hacen los mismos usuarios.

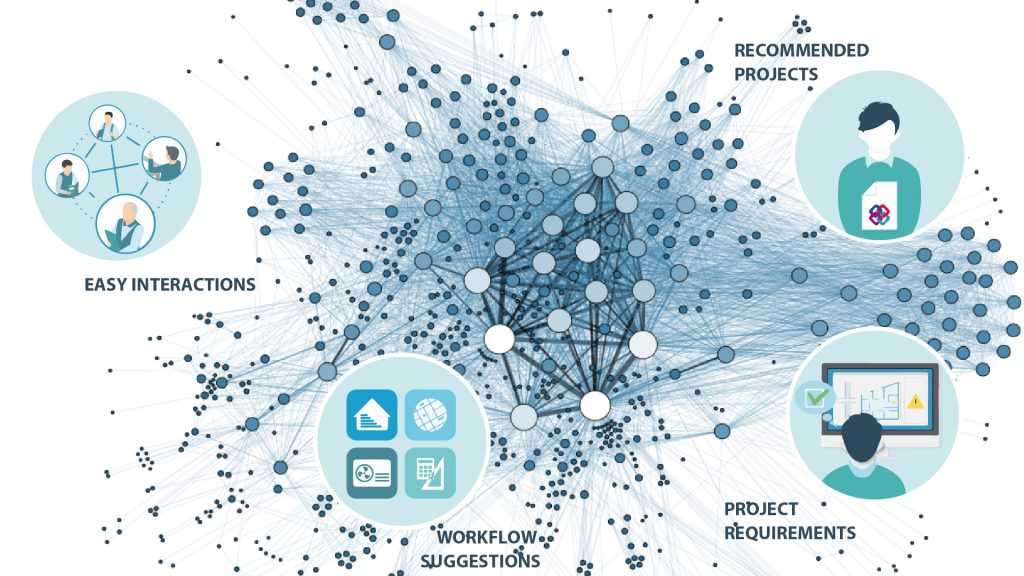

Otra de las diferencias, es que no hay un individuo que decide a quien se le puede ofrecer un producto, porque esa labor es realizada por un algoritmo cuyo funcionamiento se fortalece con la Big Data, para que distribuya los contenidos de acuerdo a los intereses de cada usuario, a los que ya tiene descritos plenamente según su edad, sexo, nivel cultural o de preparación académica, gustos, hobbies, entre otros.

Los algoritmos son preponderantes para muchas empresas

En realidad, el algoritmo es un sistema con el que se puede resolver un problema, anticiparse al mismo o más bien, demostrar que para un inconveniente determinado no existe solución alguna. La consecuencia de todo esto consiste en que esta Big Data que contiene una cantidad astronómica de datos, es la que les permitirá decidir a muchas empresas y organizaciones acerca de fenómenos sociales pertenecientes a la actualidad, porque conocen de primera mano la conducta de los usuarios de las redes sociales.

Las empresas han visto en la Big Data y los algoritmos un poder de manipulación social muy grande, lo que se evidencia en algunas aplicaciones que conocemos. Un ejemplo puede ser Google Maps, una app que le comunica al usuario el camino que debe tomar para que pueda evitar algún atasco en su trayectoria, lo que se posibilita con el uso del gps instalado en el móvil inteligente, aparte que el algoritmo de esta app puede aprender de lo ocurrido en el pasado, para predecir tendencias futuras y en caso de algún error, el algoritmo se recalibra para no errar en la siguiente ocasión.

Un hito podría ser que las corporaciones de tarjetas de crédito se dedican a vincular los datos de consumo de sus clientes, con el estado del clima en el momento que hagan su transacción, lo que determinara la forma en que se comportan estas personas durante los días muy calurosos, por lo que con el Big Data determinan por la conveniencia de lanzar ofertas en épocas como el verano, para incentivar el consumo. Para el periodismo, los algoritmos y la Big Data son sumamente útiles, porque pueden conseguir enormes cantidades de información, lo que ayudará a estos profesionales de la investigación a detectar situaciones verdaderamente importantes para presentarlas a la audiencia oportunamente.

Los comportamientos se pueden demostrar estadísticamente gracias a la Big Data, ya que implica el control y manejo de un alto volumen de información derivada de experiencias pasadas. Solo que hay que tener posibilidades tecnológicas para procesar esta información con eficacia, porque esto es lo que ayudará a tener un conocimiento profundo de la población a examinar o estudiar y así influirla en el momento más conveniente. En la política tenemos muchos ejemplos.

En el año 2008, el entonces candidato a la presidencia de Estados Unidos, Barack Obama, fue el primero en este país que tomó en cuenta el potencial que para estos propósitos políticos tienen las redes sociales, como fuente que alimenta a la Big Data para determinar el comportamiento de una población en concreto. En Estados Unidos existe la particularidad que previo al acto del sufragio, cada ciudadano debe empadronarse con antelación.

Por ende, el equipo que trabajó con Obama clasificó a aquellos usuarios de las redes sociales según las convicciones políticas reveladas por sus amigos más cercanos, lo que les permitió detectar a por lo menos 3.500.000 votantes potenciales afines al Partido Demócrata que no estaban empadronados. Posteriormente, analizaron los intereses de cada una de estas personas en lo que a la política respecta y a todos ellos de manera individual, le mandaron propuestas diversas, como las leyes de género para las partidarias del feminismo, proposiciones afines con la preservación del medio ambiente para quienes son ecologistas, intenciones de retirar a las fuerzas armadas de Afganistán para los que son pacifistas y así sucesivamente.

Para la época fue una campaña innovadora, porque su efectividad superó a las estrategias con afiches que contienen imágenes típicas de los candidatos sonrientes y felices, que no pueden mencionar nada polémico en lo absoluto, ya que en campaña electoral no les conviene decir cosas que puedan provocar alguna discordia para no alejar a los posibles votos de los que piensen diferente o que no se hayan decidido por una opción política específica.

El equipo de campaña de Barack Obama, concluyó en que de estas 3,5 millones de personas, por lo menos un millón se empadronó para ejercer el voto. Y a pesar de no determinar con exactitud cuan eficaz fue esta campaña por redes sociales, es bien cierto que Obama superó a su rival más cercano en esta oportunidad con una diferencia en votos de más de cinco millones a escala nacional, triunfando inclusive en el Estado de Florida, lugar que es clave para conseguir la presidencia porque es donde se concentra gran parte del voto de los inmigrantes latinoamericanos.

Esto fue posible gracias a que emplearon algoritmos con los que detectaron zonas de alta sensibilidad, en la que se concentraban una gran parte de sus posibles votantes, a los que analizaron para saber el tipo de mensajes con el que podrían abordarlos, herramienta de gran valía si se toma en cuenta la alta segmentación de la sociedad estadounidense, que realmente está dividida en muchos tipos de personas, con distintas aficiones, gustos preferencias y sobre todo, aspiraciones de vida.

La big data en la campaña electoral de Alexandria Ocasio-Cortez

Un caso que implica el uso de algoritmos con fines políticos, lo protagonizó Alexandria Ocasio-Cortez, diputada de ascendencia latinoamericana con tendencia socialista y que lidera la organización The Squad, en la que es acompañada por Ayanna Presley (quien es afroamericana), la representante de la comunidad musulmana en Estados Unidos, Ilhan Omar, y la activista política descendiente de palestinos, Rashida Tliab. Son mujeres que pertenecen a grupos étnicos que desde el punto de vista social y cultural, aparte de ser minoritarios en Estados Unidos, son discriminados en momentos que se impone la supremacía blanca inspirada en el presente por el actual presidente de esta nación, Donald Trump, aparte del racismo y la xenofobia que siempre han existido en este país.

Son cuatro féminas que se oponen a lo planteado no solo por Trump, sino por otros personajes como Hillary Clinton, ya que son dos íconos de la aristocracia que hace vida en Washington D.C, porque han aprendido de todas estas vivencias experimentadas por estos grupos marginados, que implican todos los problemas derivados de la inmigración para los grupos discriminados y minoritarios, empezando por el hambre y la violencia, elementos que deben sortear para lograr la hazaña de cruzar la frontera y vivir dentro del país de las oportunidades, donde podrán conseguir la felicidad anhelada. Pero esto no termina aquí, ya que viene un proceso de apropiación e integración social que no es nada fácil para el inmigrante, pero que Ocasio-Cortez lo capitalizó por medio de su discurso, lo que le ha permitido cosechar victorias políticas.

Hay que dejar bien claro que Ocasio-Cortez no se dedicó a propiciar el sectarismo político o la exclusión y marginalización, sino involucrarse directamente en las estructuras políticas de Estados Unidos. Y para ello, tuvo que manejar el uso de los algoritmos, lo que le sirvió de mucho para la consolidación de su discurso, a pesar de no tener una alta disponibilidad de fondos monetarios porque solamente consiguió para este proyecto la suma 300.000 dólares con los que financió su campaña electoral, dedicándose a un plan con el que consiguió establecer su marca para fines políticos.

Esto fue posible con los servicios de la empresa Tandem, encargada de diseñar la campaña electoral de Ocasio-Cortez. Se enfocaron en emplear estrategias con el uso de la Big Data, adecuando el lenguaje de esta lideresa a los espacios virtuales de las redes sociales, cosa que hicieron con otras organizaciones de carácter progresista en Estados Unidos: Justice Democrats y Brand New Congress.

Entonces, el trabajo de Tandem con Ocasio-Cortez implicó conectar el discurso con las peticiones de la juventud actual y los sectores sociales tradicionalmente excluidos en Estados Unidos, lo que supone una estrategia de branding, amén que esta dirigente contó con el apoyo de la empresa Means of Production (administrada por Nick Hayes y Naomi Burton), para concertar un plan con el que se buscó viralizar contenidos audiovisuales, y que estuvo dirigida a las personas de la generación millenial. Por último, en todo esto estuvo la diseñadora gráfica María Arenas, quien asumió el rol de insertar novedosas estrategias de marketing para apuntalar esta campaña con tendencia progresista.

Gracias a todo esto, Ocasio-Cortez logró acumular una gran cantidad de seguidores en Instagram y Twitter, por medio de un estudio del segmento social a impactar mediante una indagación a nivel de Big Data y una retroalimentación e interacción continua, mediante una serie de contenidos que abarcan imágenes atractivas, stories y videos cortos.

En la actualidad, Ocasio-Cortez en su rol de congresista aprovecha cada momento para sacar provecho de las maniobras de sus adversarios (sobretodo de Donald Trump), buscando desmontar su discurso para neutralizarlo en medio de una disputa comunicacional, con el que los deja expuestos ya sea como antidemocráticos o como corruptos. Y las redes sociales son vitales para estos planteamientos de Ocasio-Cortez, porque ha limitado el poder que ostentan sus rivales mediante un trabajo de marketing político excelente.

La big data le interesó a la Agencia Nacional de Seguridad de EE.UU

Hace algunos años atrás, el Gobierno de los Estados Unidos a través de la Agencia Nacional de Seguridad (National Security Agency), realizó el programa PRISM, que consistió en ingresar a los servidores de las empresas más preponderantes de la red de redes, buscando conseguir la información que ellos determinaban como de carácter estratégico para la seguridad nacional de esta nación.

Todo esto se amparó legalmente en el Foreign Intelligence Surveillance Act (FISA), por lo que con PRISM, la NSA pudo alcanzar la información que deseaban tener bajo su custodia y que tenían empresas como Facebook, YouTube, Apple, Yahoo y Google, apoderándose de contenidos en forma de documentos, textos, links, videos, archivos, entre otros formatos de información, para controlar a los que vean como adversarios, enemigos y oponentes.

Los algoritmos hacen acto de presencia en Wall Street

En Wall Street los algoritmos siempre están presentes y un caso pasó en mato de 2010, durante una jornada en que el Dow Jones perdió por algunos minutos 1.000 unidades de un solo golpe, aunque las recuperó 20 minutos después. Se trató de una especie de flash crash propiciado por los algoritmos que son usados en ordenadores, que no necesitan de la intervención de los humanos, siendo capaces de vender o comprar acciones en la Bolsa, realizando una gran cantidad de transacciones bursátiles que derivan de estrategias previamente concebidas.

Y detrás de estos planes están los “quants”, quienes se desenvuelven como analistas del entorno financiero y bursátil, aparte que tienen la destreza para crear programas informáticos que implican dentro de su programación a las matemáticas y la física y que tienen algoritmos para incidir en empresas que comercializan sus acciones en la Bolsa, apoderándose de sustanciosos beneficios económicos.

Facebook ya había experimentado con su propia Big Data

En el 2014, Facebook hizo un experimento con un propósito de análisis psicológico, involucrando a cerca de un millón de usuarios que no estaban al tanto de este proyecto. La finalidad de esto, es ver como reaccionaban ante una serie de informaciones que visualizarían en sus páginas, buscando fomentar una especie de contagio emocional, aparte que verificarían si esto podía ser manipulado.

El resultado de todo esto, según lo comentado por la Academia Nacional de Ciencias de los Estados Unidos, es que un individuo puede contagiar a otros con sus emociones, sin que terceros se percaten de esta situación ni que haya un contacto verbal o físico, ya que basta con los comentarios compartidos entre los usuarios, para fomentar esta circunstancia, analizando para ello una cantidad superior a los tres millones de comentados que en el marco de este experimento se postearon.

Unión de Facebook y Cambridge Analytica para incidir en comicios electorales

Las instituciones políticas y los lobbies empresariales tienen bien claro el poder de los algoritmos, porque son un elemento de suma utilidad para controlar a una nación en los aspectos económicos sociales y políticos, dado que podrán imponer sus ideas y criterios para manipular a la población en general, acentuando su posición dominante muy por encima de la que poseen los ciudadanos comunes.

En el primer trimestre del 2018, los rotativos The New York Times, The Observer y The Guardian, publicaron un trabajo de investigación en el que laboraron de manera mancomunada, con el que demostraron que la compañía Cambridge Analytica obtuvo información personal de manera fraudulenta, para determinar los perfiles que hacían alusión a millones de estadounidenses que habrían otorgado su voto a Donald Trump en los comicios presidenciales que se llevaron a cabo a finales de 2016, lo que le permitió instalarse en La Casa Blanca como el nuevo Presidente de los Estados Unidos.

De acuerdo a The Guardian, se estima que tomaron la información que corresponde a un mínimo de 50 millones de ciudadanos, cifra que alcanzaría el tope de 75 millones de personas. Robert Mercer (dueño de un porcentaje de las acciones de Cambridge Analytica y patrocinante de organizaciones políticas partidarias de extrema derecha), es el principal involucrado en este caso, junto con el integrante del consejo administrativo de esta empresa y colaborador cercano de Donald Trump, Stephen Bannon.

El asunto tuvo una gran notoriedad pública, a tal punto que el creador de la red social Facebook, Mark Zuckerberg, tuvo que salirle al paso a este problema al comentar públicamente que esta empresa no hizo los esfuerzos necesarios y suficientes para resguardar la información que pertenece a estos usuarios, dado que, de acuerdo a su criterio, cada una de estas personas compartieron sus datos sin protegerlos debidamente, lo que facilitó la extracción de esta información contenida en las páginas de Facebook. Por otro lado, Zuckerberg alegó que nunca consideraron la posibilidad que estos datos individuales fueran manejados por otras personas o instituciones, razón por la que harán lo necesario para que a futuro esto no se repita.

Es necesario destacar, que Estados Unidos no fue el único país en el que Cambridge Analytica hizo este trabajo, con el que influyó fuertemente en el electorado para que emitiera su voto a favor de una persona en particular. Esto también pasó en naciones como Argentina, Kenia, India y Nigeria. Alexander Nix, quien fue consejero delegado en esta compañía, fue el responsable de este proceso, que también alcanzó al asesor de seguridad de Trump, John Bolton, porque también estaba vinculado con Cambridge Analytica, relación que fue de gran provecho para apoderarse la información de millones de perfiles de usuarios que estaban almacenados en los servidores de Facebook, ayudando con esto a que Trump consiguiera la presidencia de Estados Unidos.

Los algoritmos y la big data para la seguridad ciudadana

Algunos cuerpos policiales estadounidenses, han usado los algoritmos y la Big Data para saber cuan peligrosa puede ser una persona y que posibilidad existe que un ciudadano común incurra en la comisión de algún delito, lo que acelera el trabajo de las instituciones que administran justicia porque saben de manera adelantada si deben condenar o absolver de cualquier cargo a una persona y como muestra de esto tenemos que:

A.- La Policía de la ciudad de Memphis, Tennessee, aplicó mediante el uso de algoritmos al plan Blue Crush, para detener a 1.200 personas luego de realizar una indagación basada en estadísticas criminales

B.- La Policía de Chicago, Illimois, cuenta con una lista secreta conformada por los datos de 400.000 ciudadanos a los que han estudiado según su nivel de peligrosidad. Aparte que tienen la capacidad para determinar lo peligroso que puede ser un ciudadano que jamás ha sido detenido por cometer una transgresión a la ley.

Los algoritmos posibilitan la manipulación de las personas

Recurrir a los algoritmos no es otra cosa sino conseguir un poder que puede transformar la conducta de una sociedad, algo a lo que muy pocos tienen acceso porque cuesta mucho dinero. Pero esto cercena la libertad de pensamiento y la justicia social en favor de las personas porque la posibilidad de tener criterio propio y sentido crítico por parte de un ciudadano desaparece a partir del instante en que su privacidad en la red de redes es violentada, por el manejo poco conveniente de su información personal.

Es como un régimen dictatorial cibernético, en el sentido que la información propiedad de cada individuo es usada por instituciones gubernamentales y no gubernamentales, así como por las corporaciones de cualquier sector económico, asunto en el que no existen controles de ningún tipo, quedando las personas a merced de quien desee manejar su voluntad, bien sea por motivos comerciales o político-electorales, porque en una etapa de campaña electoral es necesario sumar voto a voto para apoderarse de un cargo de elección popular. Pero esto pulveriza la capacidad de conciencia y el libre albedrío que como humanos podemos tener, dando al traste con la auténtica democracia.

Definitivamente los algoritmos están en todo

Mientras las redes sociales sean una fuente de noticias importante para la población, esta clase de campañas de marketing a través de Internet serán soberbiamente efectiva. Así se pueden concebir los procesos comunicacionales que alcanzan al público con una serie de mensajes que son distribuidos con algoritmos, solo que estos contenidos se enfocan en determinados tipos de personas, por lo que dos individuos pueden estar inmersos en realidades disimiles.

Realmente, los algoritmos ayudan a captar la atención de la persona que observa los contenidos en la pantalla de un dispositivo, basado en lo que tiempo atrás le causó interés. Sin embargo, la sociedad se fragmenta progresivamente, lo que profundiza el individualismo dentro de una carencia de sentido crítico para entender lo que realmente nos sucede y nos rodea, por lo que cada quien tiene una realidad construida a su medida, con un horizonte determinado por otros.

Hoy por hoy, tenemos a los vehículos que funcionan de manera autónoma que a pesar de no estar tan arraigados, representan el futuro de la movilidad y el transporte de pasajeros. Estos coches tienen la capacidad de decidir automáticamente sin tomar en cuenta lo que piense el dueño, lo que implica entre muchas cosas la adquisición del combustible necesario en la estación de servicio que considere más conveniente, o buscar el taller en el que se deba efectuar una reparación al automóvil, ya sea por razones geográficas o económicas.

Tanto en nuestro ordenador como en los móviles, hay asistentes personales que en teoría nos ayudan a ahorrar más tiempo al momento de hacer cualquier trabajo de nuestra cotidianidad. Para muestra tenemos al asistente Siri o a Google Assistant, que en el fondo parece que están hechos para controlar a la gente, porque están programados para conocer al usuario que recurre a estos desde el mismo momento en que inician sesión.

Lo importante con los algoritmos y la Big Data, es que no solo se trata de comercializar un servicio o un producto, sino de encauzar los pensamientos de los habitantes de una sociedad en un solo rumbo, sin que estos se percaten que los manejan con suma habilidad.

Ya hemos visto cómo funcionan los algoritmos de los principales motores de búsqueda, o como es que Google determina la manera en que se puede abordar publicitariamente a una persona, revisando su historial de navegación en Internet durante un tiempo determinado.

Con Amazon puede pasar lo mismo, porque con el sistema de recomendaciones de esta tienda online, basado en los comentarios posteados por otros clientes o usuarios, pueden influir en las decisiones de los clientes interesados en un producto en particular, aparte que constantemente envían al correo electrónico del usuario, recomendaciones de ofertas y productos que emanan de su historial de búsqueda.

Todo esto queda bajo las condiciones en que se usan tales servicios de Internet, lo cual muchas personas no ven porque simplemente lo aprueban y ya y es lo que allana el camino para que todas estas empresas que están en la red de redes, pasen por encima de la privacidad que debe proteger a los datos de las personas.

Lo que no se debe olvidar es que nuestras vidas estarán controladas por los algoritmos, elementos informáticos que organizan grandes cantidades de información emanada de la Big Data, controlando a millones de personas que no perciben el proceso de manipulación, dominación y sometimiento en el que han caído, debido a los intereses de las clases sociales económicamente poderosas.